L’audit initial, on le prépare souvent “comme un examen”. L’audit de surveillance, lui, fonctionne plutôt comme un contrôle de routine… sur la vraie vie : ce qui a été fait depuis l’audit initial, comment l’équipe suit ses actions, et si la démarche qualité tourne encore sans “béquilles”.

C’est précisément pour ça que certains indicateurs tombent plus souvent que d’autres : ils exigent des preuves régulières, pas un dossier figé.

Audit de surveillance : les règles du jeu

Sur le plan réglementaire, l’audit de surveillance ne se limite pas à “refaire” l’audit initial. Il doit notamment porter une attention particulière :

- aux indicateurs qui avaient déjà fait l’objet de non-conformités (et à l’efficacité des actions correctives),

- aux indicateurs qui ne peuvent donner lieu qu’à des non-conformités majeures,

- et à un socle d’indicateurs systématiquement vérifiés, dont les indicateurs 1, 17 et 19 (et l’indicateur 3 si l’organisme est concerné).

Autre point important : l’auditeur procède par échantillonnage d’actions et la conformité repose sur une appréciation de la mise en œuvre réelle, pas sur la présence d’un document “pour faire joli”.

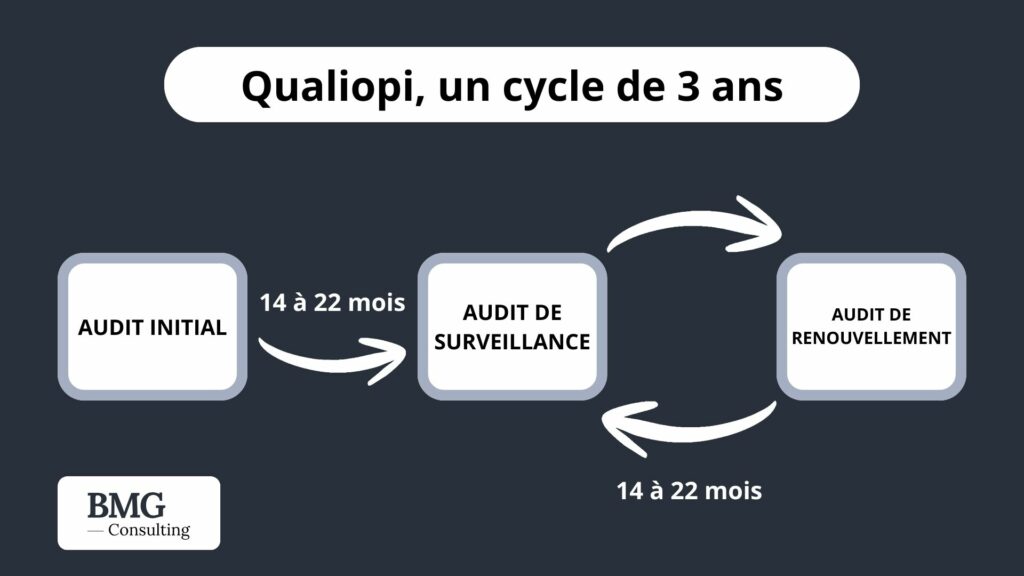

Enfin, côté calendrier, l’audit de surveillance intervient en cours de cycle, typiquement entre le 14e et le 22e mois après l’obtention (ou le renouvellement) : c’est court, et ça laisse peu de place à l’improvisation si le suivi n’est pas cadré.

Les indicateurs qui “cassent” le plus souvent

1) Indicateur 1 : information du public… et cohérence des supports

C’est un grand classique : le site web, les plaquettes, les programmes, les devis… ne racontent pas la même histoire ou ne sont pas à jour (objectifs flous, délais d’accès absents, résultats non actualisés, infos handicap oubliées, etc.). En surveillance, ça se voit tout de suite, parce que l’auditeur compare vos engagements affichés à ce qui se passe réellement.

Bon réflexe : une mini-revue trimestrielle des contenus “publics” (page programme, CGV/CGU si besoin, modèles de devis/conventions), avec trace de mise à jour.

2) Indicateurs 17 et 19 : moyens, environnement et ressources pédagogiques (obligatoires en surveillance)

Ces deux indicateurs font partie de ceux que l’audit de surveillance va forcément regarder. Ils touchent à des sujets très concrets :

- 17 : moyens humains/techniques adaptés, environnement approprié (locaux, équipements, plateaux techniques, outils).

- 19 : ressources pédagogiques mises à disposition et appropriation par le bénéficiaire.

Dans la pratique, les écarts viennent souvent d’un décalage entre le “discours” et le terrain : livret d’accueil annoncé mais jamais remis, outils numériques mentionnés mais non utilisés, supports obsolètes, accès aux ressources pas clair.

Bon réflexe : pour chaque parcours échantillonné, préparez une démonstration simple : “voici les ressources”, “voici comment l’apprenant y accède”, “voici la preuve d’appropriation” (consignes, activités, traces LMS, travaux, émargements, etc.).

3) Compétences et actualisation des intervenants (indicateurs 21–23 selon votre organisation)

Les audits de surveillance sanctionnent rarement le manque de compétence… mais très souvent le manque de preuves à jour : CV datés, justificatifs absents, veille non structurée, dossier formateur incomplet.

Et attention : certains indicateurs liés à la maîtrise opérationnelle (dont 21 et 22) figurent parmi ceux qui ne peuvent donner lieu qu’à des non-conformités majeures selon l’arrêté : autrement dit, le risque est plus élevé si l’attendu n’est pas tenu.

Bon réflexe : un “dossier intervenant” vivant (CV récent + diplômes/attestations + expériences récentes + preuves de formation continue + traces de veille partagées).

4) Critère 7 : appréciations et réclamations (indicateurs 30 à 32)

C’est le bloc qui fait mal en surveillance, parce qu’il oblige à prouver une boucle complète :

recueillir → analyser → décider → améliorer.

Le guide de lecture insiste notamment sur la sollicitation des appréciations (pas uniquement des bénéficiaires ; et pour les financeurs, ce n’est pas nécessairement à chaque action, mais au minimum avec une logique suivie). Et il rappelle qu’une simple évaluation des acquis ne suffit pas à prouver cet attendu.

En parallèle, beaucoup d’organismes tombent sur la partie “réclamations” parce qu’ils répondent : “On n’en a jamais eu”… sans processus prêt, communiqué et traçable.

À noter : l’arrêté liste 31 et 32 parmi les indicateurs pouvant entraîner uniquement des non-conformités majeures. Donc si votre pilotage des retours/réclamations est fragile, l’enjeu est immédiat.

Bon réflexe : montrez des traces “d’amélioration continue” qui parlent : décisions d’équipe, actions correctives, ajustements de contenus, mise à jour de supports, changement de modalité… reliés à des retours réels.

Une mini-checklist simple

- 1 document “revue trimestrielle” des infos publiques (site + programmes + modèles).

- 1 preuve claire “moyens & ressources” sur un parcours échantillon (accès + usage).

- 1 dossier formateur/intervenant à jour (compétences + veille).

- 1 tableau de satisfaction exploité (pas juste collecté).

- 1 registre réclamations + procédure + preuve de communication.

- 1 log d’amélioration continue (décisions + actions + date + impact).

L’idée à retenir

Les “indicateurs à risque” ne sont pas forcément les plus complexes : ce sont ceux où l’auditeur attend une régularité, une traçabilité et une cohérence entre ce que vous annoncez et ce que vous faites. C’est exactement la logique de l’audit par échantillonnage et de l’appréciation de la mise en œuvre réelle rappelée par le guide de lecture.